Êtes-vous un marcheur heureux, triste ou en colère ? Nos émotions peuvent influer sur tout, de nos appétits à notre façon de percevoir le monde et même de marcher.

Alors, est-il possible d’interpréter comment une personne se sent en se basant uniquement sur sa démarche ? Les scientifiques de l’Université de Caroline du Nord à Chapel Hill et de l’Université du Maryland à College Park ont prouvé que c’est possible. Ils enseignent des algorithmes pour percevoir les émotions basées sur la démarche seule.

Comment ils peuvent réaliser cela ?

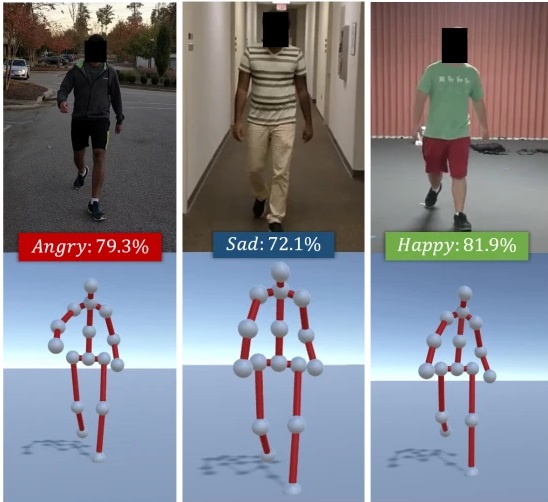

En utilisant l’apprentissage en profondeur, leur logiciel peut analyser une vidéo de quelqu’un qui marche, la transformer en un modèle 3D et extraire sa démarche. Un réseau de neurones détermine ensuite le mouvement dominant et sa correspondance avec un sentiment particulier, en fonction des données sur lesquelles il est entraîné. Selon leur article de recherche, publié en juin sur arXiv, leur modèle d’apprentissage en profondeur peut deviner quatre émotions différentes – heureuse, triste, en colère et neutre – avec une précision de 80%.

Bien que nous ayons vu des IA entraînées à prédire ce que les gens ressentent en fonction de leurs expressions faciales ou même de leur voix, c’est la première fois qu’un algorithme a été formé pour faire une estimation précise en regardant simplement quelqu’un marcher.

« La recherche ne détecte pas une émotion réelle »

Aniket Bera, directeur de recherche et professeur d’informatique à l’Université du Maryland, a déclaré au blog de science et technologie Techxplore que leur recherche n’essayait pas de détecter une émotion réelle. Elle prédisait plutôt une émotion perçue, tout comme les gens se prédisent les uns les autres. Selon Bera, le travail pourrait apprendre aux robots à anticiper les sentiments de leur entourage et à adapter leur comportement en conséquence. Ou l’inverse : cela pourrait aider les ingénieurs à concevoir des robots pour une meilleure communication innée avec leur démarche et leurs mouvements corporels.